目录1.在usr目录下创建Hadoop目录,将安装包导入目录中并解压文件2.进入vim/etc/profile文件并编辑配置文件3.使文件生效4.进入Hadoop目录下5.编辑配置文件6.进入sla...

目录

- 1.在usr目录下创建Hadoop目录,将安装包导入目录中并解压文件

- 2.进入vim /etc/profile文件并编辑配置文件

- 3.使文件生效

- 4.进入Hadoop目录下

- 5.编辑配置文件

- 6.进入slaves添加主节点和从节点

- 7.将各个文件复制到其他虚拟机上

- 8.格式化hadoop (仅在主节点中进行操作)

- 9.回到Hadoop目录下(仅在主节点操作)

1.在usr目录下创建Hadoop目录,将安装包导入目录中并解压文件

gt;

<property>

<!--指定Mapreduce运行在yarn上-->

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!--开启MapReduce的小任务模式-->

<property>

<name>mapred.job.ubertask.enable</name>

<value>true</value>

</property>

<property>

<name>mapred.job.tracker</name>

<value>z1:9001</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>CMaster:10020</value>

</property>

</configuration>

>yarn.nodemanager.vmem-pmem-ratio</name>

<value>2.1</value>

</property>

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>1024</value>

</property>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

</configuration>

;configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/hadoop/hadoop-2.6.0/hadoopDesk/namenodeDatas</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/hadoop/hadoop-2.6.0/hadoopDatas/namenodeDatas</value>

</property>

<property>

<!--副本个数-->

<name>dfs.replication</name>

<value>3</value>

</property>

<!--设置hdfs的文件权限-->

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

<!--设置一个文件切片的大小:128m-->

<property>

<name>dfs.bloksize</name>

<value>134217728</value>

</property>

</configuration>

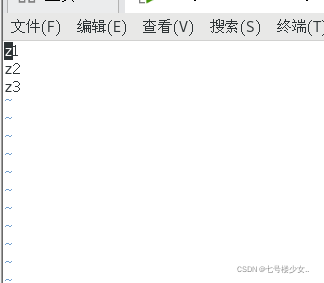

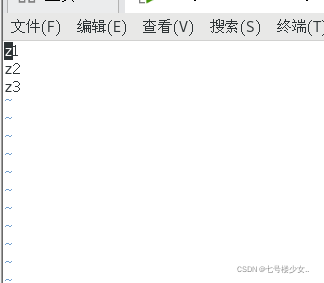

6.进入slaves添加主节点和从节点

添加自己的主节点和从节点(我的是z1,z2,z3)

7.将各个文件复制到其他虚拟机上

scp -r /etc/profile root@z2:/etc/profile #将环境变量profile文件分发到z2节点

scp -r /etc/profile root@z3:/etc/profile #将环境变量profile文件分发到z3节点

scp -r /usr/hadoop root@z2:/usr/ #将hadoop文件分发到z2节点

scp -r /usr/hadoop root@z3:/usr/ #将hadoop文件分发到z3节点

生效两个从节点的环境变量

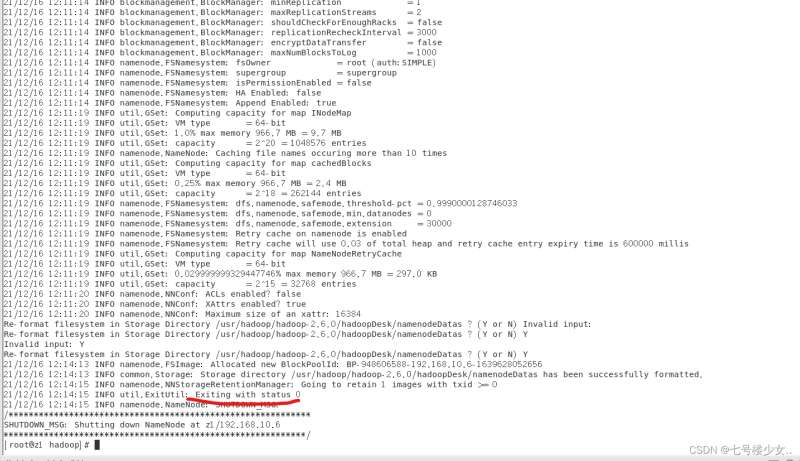

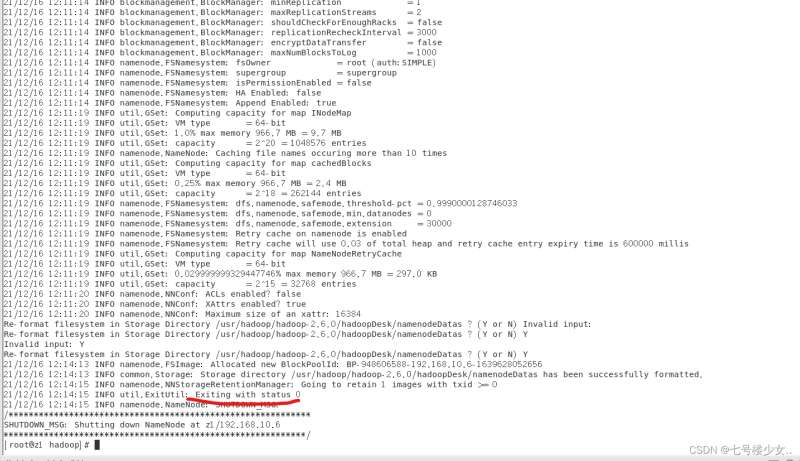

8.格式化hadoop (仅在主节点中进行操作)

首先查看jps是否启动hadoop

当看到Exiting with status 0时说明格式化成功

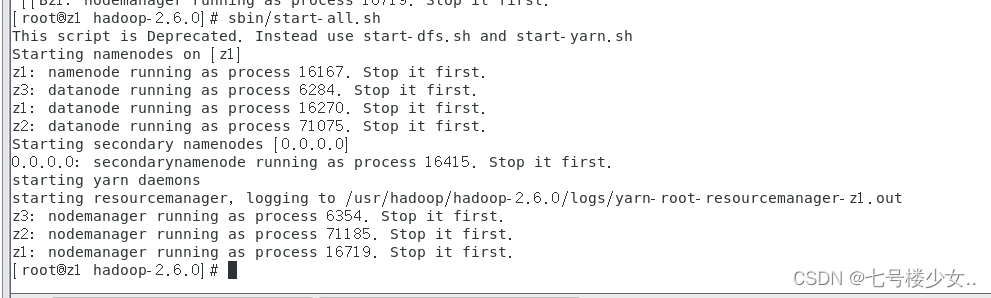

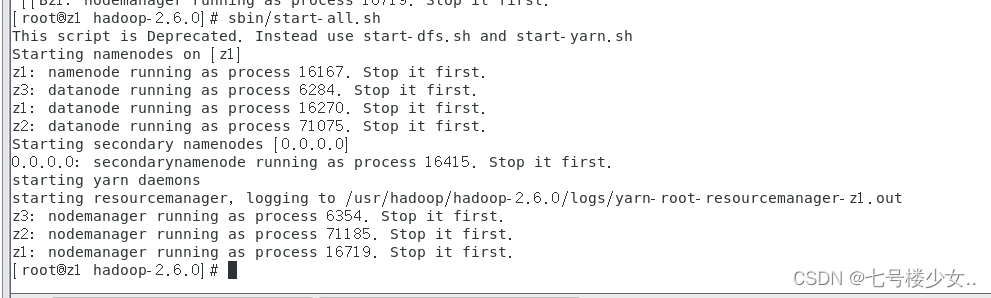

9.回到Hadoop目录下(仅在主节点操作)

cd /usr/hadoop/hadoop-2.6.0

sbin/start-all.sh 启动Hadoop仅在主节点操作

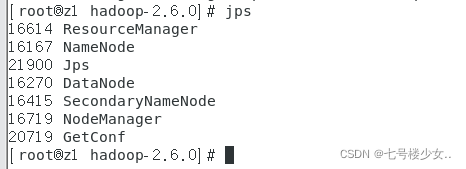

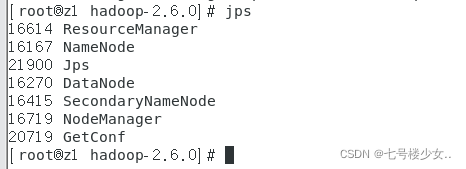

主节点输入jps效果:

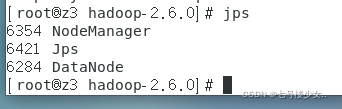

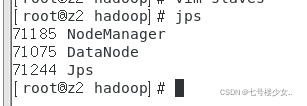

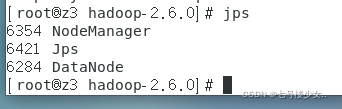

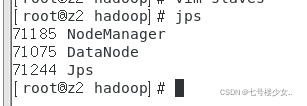

从节点输jps效果:

到此这篇关于linux下安装Hadoop集群详细步骤的文章就介绍到这了,更多相关Linux安装Hadoop集群内容请搜索我们以前的文章或继续浏览下面的相关文章希望大家以后多多支持我们!

本站部分内容来源互联网,如果有图片或者内容侵犯您的权益请联系我们删除!